AI Agent 工程化十二要素详解

这个项目是 HumanLayer 团队提出的“12‑Factor Agents”,借鉴 Heroku 的 12‑Factor App 方法,总结出构建生产级 LLM Agent 的十二条工程原则,覆盖从 结构化工具调用、Prompt 管控、上下文管理、状态与控制流分离,到 人机协作、无状态设计、错误处理 等关键逻辑。其价值在于将不确定的 LLM 整合到“可靠、可扩展、易维护”的成熟软件架构中,帮助开发团队跨越常见的 70‑80% 可用性瓶颈,将 AI Agent 真正推向生产环境。

12‑Factor Agents 项目内容体系略显庞大,涵盖从工具调用到状态管理的十二个核心维度,对于初学者而言理解门槛较高。为降低学习成本,提升开发效率,特别借助 Claude Sonnet 4 的强大分析能力,对项目核心要点进行深度解读。通过 AI 辅助梳理,将复杂的工程原则转化为结构化的知识框架,让开发者能够快速把握每个要素的核心思想与实践意义。以下是经过系统整理的详细内容,帮助您在最短时间内掌握生产级 AI Agent 的构建精髓,从而加速从概念验证到生产部署的技术跨越。

Factor 1: 自然语言到工具调用 (Natural Language to Tool Calls)

核心思想: LLM 的核心功能应该是解析自然语言指令并将其转换为结构化的、可执行的工具调用

关键要点:

- 角色定位: 将 LLM 从简单的文本生成器提升为智能路由器;

- 桥接作用: 连接人类意图和程序化行动之间的桥梁;

- 确定性执行: 通过工具调用与确定性后端交互,确保可预测和可靠的任务执行;

- 结构化输出: 强调生成明确的、有类型的工具调用而非自由文本;

实践意义:

- 每个用户输入都应该被转换为明确的工具调用;

- 避免让 LLM 直接执行不可预测的操作;

- 建立清晰的输入-工具调用-执行链条;

Factor 2: 掌控你的提示词 (Own Your Prompts)

核心思想: 提示词是 LLM 交互的生命线,应该被视为关键的、版本控制的代码工件而非一次性输入

关键要点:

- 版本控制: 提示词应该在应用程序代码库中进行管理;

- 系统化测试: 提供系统化的测试、部署和回滚能力;

- 一致性保证: 确保行为的一致性和可重现性;

- 受控演进: 能够以受控的方式演进 Agent 的行为;

实践意义:

- 将提示词作为代码的一部分进行管理;

- 建立提示词的测试和部署流程;

- 根据模型变化调整 token 顺序和系统/用户角色;

Factor 3: 掌控你的上下文窗口 (Own Your Context Window)

核心思想: 上下文窗口是 LLM 对之前交互的有限记忆,需要主动和有意识的管理

关键要点:

- 相关性过滤: 确保上下文窗口只包含与当前任务直接相关的信息;

- 信息裁剪: 修剪不必要的数据以防止"上下文漂移"或信息过载;

- 性能优化: 提高 LLM 性能,减少 token 使用;

- 焦点增强: 增强模型专注于关键细节的能力;

实践意义:

- 主动管理上下文内容,避免无关信息干扰;

- 实现智能的上下文压缩和摘要;

- 建立上下文窗口的清理和优化机制;

Factor 4: 工具就是结构化输出 (Tools Are Just Structured Outputs)

核心思想: 工具被定义为 LLM 被训练或指示生成的特定结构化数据格式

关键要点:

- 关注点分离: LLM 专注于智能推理和生成,实际执行由可靠的确定性代码处理;

- 结构化数据: 工具调用是清晰、可解析的输出格式;

- 执行分离: 不依赖 LLM 直接执行操作,而是生成执行指令;

- JSON 本质: 工具本质上是触发确定性代码操作的 JSON 输出;

实践意义:

- 设计清晰的工具调用 JSON schema;

- 建立工具调用的验证和执行机制;

- 确保工具调用的可解析性和可靠性;

Factor 5: 统一执行状态和业务状态 (Unify Execution State and Business State)

核心思想: 强调对 LLM 内部"执行状态"(LLM 认为正在发生的事情)和应用程序实际"业务状态"(实际情况)的清晰和一致理解

关键要点:

- 状态一致性: 防止 LLM 的认知状态与实际业务状态产生偏差;

- 准确信息: 确保 LLM 使用准确和最新的信息进行操作;

- 幻觉防护: 防止幻觉或无效操作的产生;

- 真实性保证: 维护业务逻辑的真实性和一致性;

实践意义:

- 建立状态同步机制;

- 实现状态验证和校正流程;

- 确保 LLM 始终基于准确的业务状态进行决策;

Factor 6: 通过简单 API 实现启动/暂停/恢复 (Launch/Pause/Resume with Simple APIs)

核心思想: LLM 代理应该设计为具有清晰的程序化接口,允许轻松的生命周期管理

关键要点:

- 生命周期管理: 提供启动新代理实例、暂停执行、从特定状态恢复的简单 API;

- 调试支持: 对调试、测试和管理长时间运行或复杂代理工作流至关重要;

- 状态检查: 使开发人员能够在任何时点介入和检查代理的行为;

- 可恢复性: 支持从中断点恢复执行;

实践意义:

- 设计清晰的 Agent 生命周期 API;

- 实现状态序列化和反序列化;

- 建立 Agent 的暂停和恢复机制;

Factor 7: 通过工具调用联系人类 (Contact Humans with Tool Calls)

核心思想: 总会有需要人类判断、专业知识或干预的情况,应该通过工具调用明确将"人类联系"构建到代理的能力中

关键要点:

- 人类干预: 当 LLM 遇到模糊性、不确定性或需要外部批准时,应该能够触发结构化的通知或升级给人类操作员;

- 自治边界: 确保在需要人类监督时,关键决策不会自主做出;

- 升级机制: 建立明确的人机协作流程;

- 工具化联系: 将人类联系作为标准工具调用实现;

实践意义:

- 设计人类介入的工具调用接口;

- 建立人机协作的工作流程;

- 实现智能的升级和通知机制;

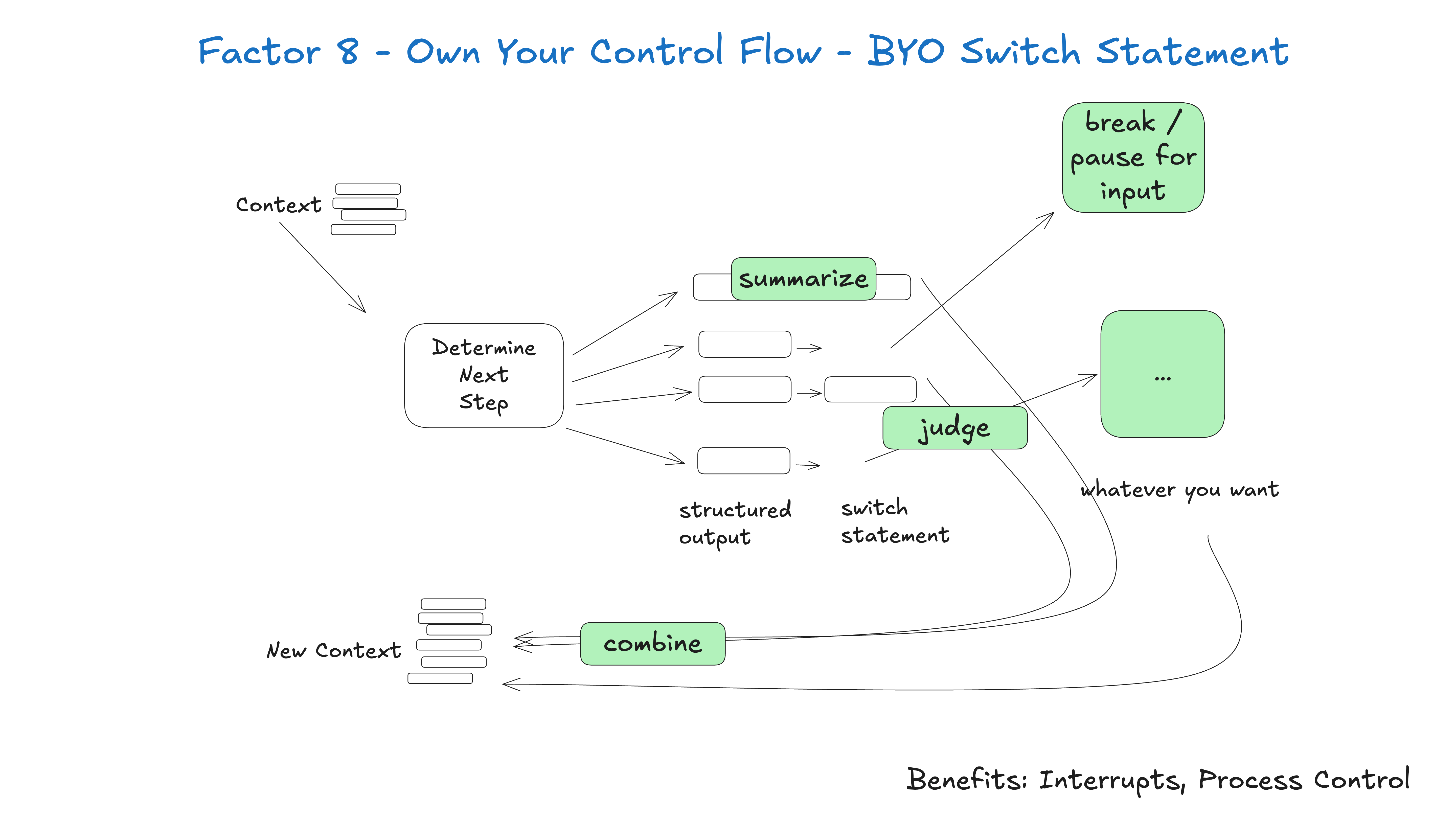

Factor 8: 掌控你的控制流 (Own Your Control Flow)

核心思想: 尽管 LLM 具有"推理"能力,应用程序的总体控制流应该保持由确定性代码明确定义和管理

关键要点:

- 控制流所有权: LLM 应该指导通过控制流的路径,而不是成为控制流本身;

- 可预测性: 确保可预测性,启用强健的错误处理;

- 自治边界: 允许开发人员为 LLM 的自治建立明确的边界;

- 行为控制: 防止意外或不期望的行为;

实践意义:

- 设计明确的控制流图;

- 让 LLM 在预定义的路径中做选择;

- 建立错误处理和异常管理机制;

Factor 9: 将错误压缩到上下文窗口 (Compact Errors into Context Window)

核心思想: 当 LLM 驱动的应用程序发生错误时,为 LLM 提供简洁和相关的失败信息至关重要

关键要点:

- 结构化错误: 以结构化方式将错误详细信息压缩到 LLM 的上下文窗口中;

- 理解能力: 使 LLM 能够更好地理解问题并可能建议恢复策略或替代操作;

- 信息过滤: 避免向 LLM 提供原始的、冗长的错误日志,这可能会混淆它;

- 自愈能力: 让模型能够基于错误信息进行自我修复;

实践意义:

- 设计错误信息的摘要和压缩机制;

- 建立错误分类和处理流程;

- 实现基于错误的恢复策略;

Factor 10: 小而专注的代理 (Small, Focused Agents)

核心思想: 将复杂的 LLM 应用程序分解为更小、更专业的代理,每个代理负责一个不同的任务或领域

关键要点:

- 模块化方法: 减少任何单个 LLM 的认知负载;

- 精度提升: 通过缩小焦点提高其准确性;

- 可维护性: 使系统更容易开发、测试和维护;

- 优化友好: 较小的代理更适合特定的微调和优化;

实践意义:

- 按功能领域拆分 Agent;

- 建立 Agent 间的协作机制;

- 实现专业化的 Agent 设计;

Factor 11: 在任何地方触发,在用户所在之处相遇 (Trigger from Anywhere, Meet Users Where They Are)

核心思想: 可靠的 LLM 应用程序应该可以从多样的入口点和用户界面访问和触发

关键要点:

- 多渠道访问: 无论是通过 web 聊天、API 调用、移动应用还是内部仪表板,代理都应该能够无缝接收输入和交付响应;

- 集成灵活性: 确保代理可以集成到现有工作流程中;

- 用户体验: 在用户偏好的平台上与用户相遇,增强可用性和采用;

- 无处不在: 提供无处不在的访问能力;

实践意义:

- 设计多渠道的接入接口;

- 建立统一的 Agent 服务层;

- 实现跨平台的用户体验;

Factor 12: 让你的代理成为无状态的 Reducer (Make Your Agent a Stateless Reducer)

核心思想: 鼓励将 LLM 代理设计为无状态的,处理输入并产生输出,而不在交互之间维护内部的长期记忆

关键要点:

- 无状态设计: 代理不维护内部状态,所有必要的持久状态由外部数据存储管理;

- 可扩展性: 增强可扩展性、弹性和水平扩展能力;

- 实例无关性: 任何代理实例都可以处理任何请求;

- 容错性: 单个实例的失败不会导致数据丢失;

实践意义:

- 设计无状态的 Agent 架构;

- 实现外部状态存储和管理;

- 建立水平扩展的能力;

总体架构思想

这 12 个因子共同构建了一个完整的生产级 AI Agent 架构框架,强调:

- 确定性与可预测性 - 通过明确的控制流和工具调用;

- 可维护性与可扩展性 - 通过模块化和无状态设计;

- 人机协作 - 通过明确的人类介入机制;

- 状态管理 - 通过统一的状态管理和上下文控制;

- 错误处理 - 通过结构化的错误压缩和处理;

- 多渠道部署 - 通过灵活的触发和访问机制;

这些原则的核心目标是将 AI Agent 从"有时工作的演示"转变为"可靠的生产系统"。项目具有重要的行业价值,它准确识别并系统化解决了 AI Agent 从"演示级"跨越到"生产级"的关键瓶颈。项目最大亮点是提出"混合架构"理念——最佳 Agent 应以确定性代码为主体,在关键点融入 LLM,这一洞察挑战了主流框架的纯 AI 驱动思路。基于与 100 多个 SaaS 构建者的实践交流,该项目不仅提供了系统化的工程原则,更重要的是确立了从工程角度审视 Agent 开发的思维框架。虽然存在复杂性权衡和框架适用性等局限,但其对推动 AI Agent 标准化和提升行业工程质量具有里程碑意义,很可能成为该领域的重要参考标准,适合所有面临 Agent 生产化挑战的工程团队参考。